黃仁勳開講3|聯手台積電、鴻海、國科會打造超級電腦 建台灣AI基礎設施

【記者蕭文康/台北報導】NVIDIA執行長黃仁勳今天也帶來好消息,他說今天非常高興地宣布,「台灣不只是為世界打造超級電腦,我們也正在為台灣打造人工智慧(AI),包括鴻海、台灣政府(國科會)、NVIDIA 和台積電將合作,在這裡打造第一座大型 AI 超級電腦,作為台灣 AI 基礎設施和 AI 生態系統的基石」,現場響起熱烈掌聲。

Mdlane 和 Blackwell由和碩、廣達、緯創 打造、富士康、技嘉和華碩共同研發

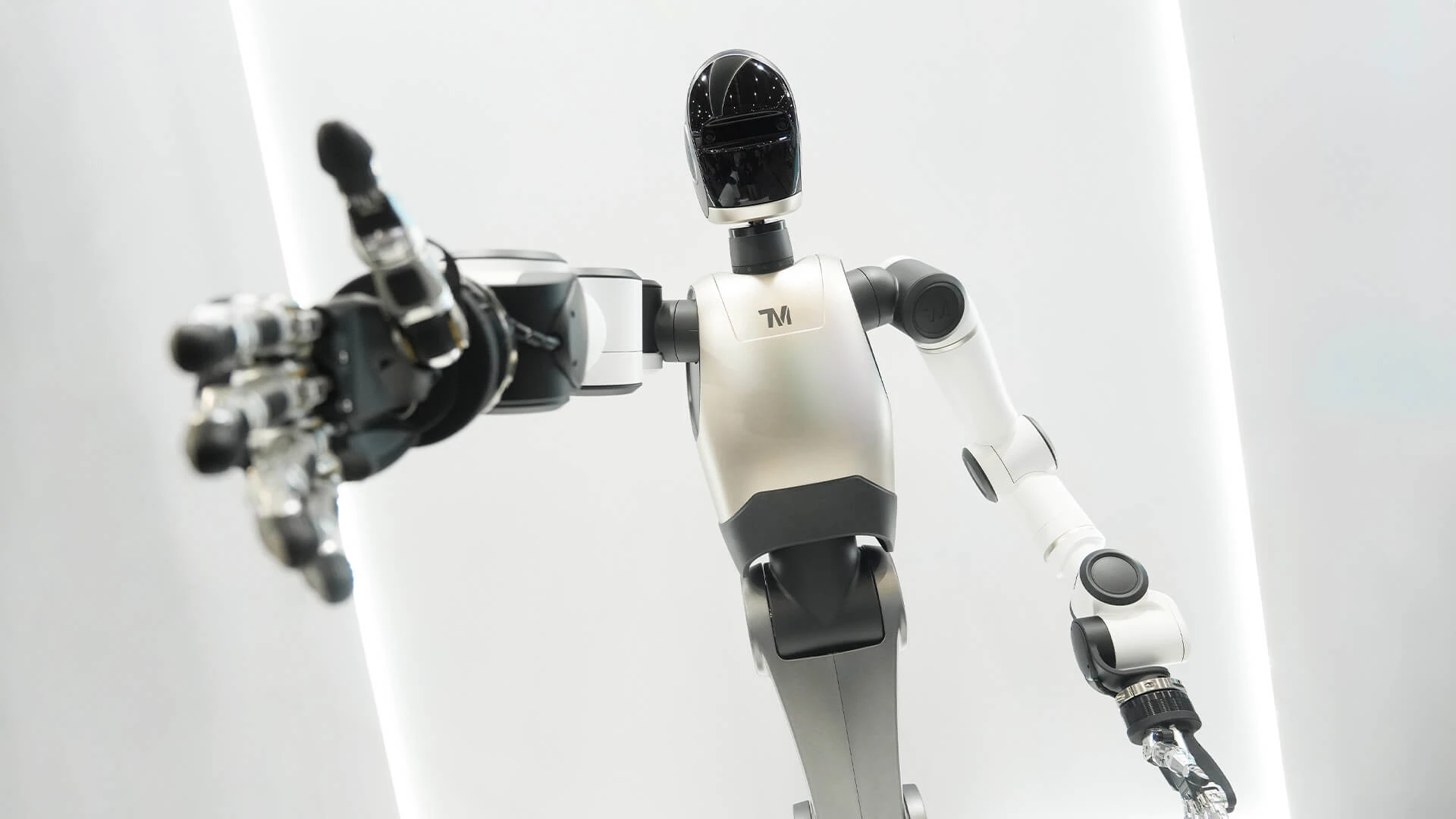

黃仁勳問現場有沒有人需要 AI 電腦?有任何 AI 研究人員在場嗎?每一位學生、每一位研究人員、每一位科學家、每一家新創公司、每一家大型企業,像台積電本身就投入大量 AI 與科學研究。同樣地,鴻海也在機器人領域進行大量的工作。他說他知道現場有許多其它公司,也都在做機器人和 AI 研究,擁有世界級的 AI 基礎設施對台灣真的非常重要。

這一切都是為了打造一款非常大型的晶片,這一代的 Mdlane 和 Blackwell 讓我們能夠創造這樣令人驚嘆的系統。這是由和碩、廣達、緯創 打造的,這是鴻海、技嘉和華碩共同研發的,可以看到它的正面和背面。整個系統的目標就是將那些巨大的 Blackwell 晶片,結合成一顆超大晶片。

當然,能做到這一點是得益於 Mdlane,但在其他層面上,例如系統架構的複雜性、將所有元件連結起來的豐富軟體生態系統,以及由 150 家公司共同打造的整個架構和技術、生態、軟體與產業體系,這是一項歷時三年的艱鉅工程,這是一項龐大的產業投資。

接下來,誰想讓這件事成真呢?適合任何人。任何想要建置資料中心的人都適用。這可能是由許多 NVIDIA GP200、300 系列及 NVIDIA 加速運算系統所構成,也可能是由其他廠商打造。

NVLink Fusion打造半客製化晶片、整體的 AI 基礎設施

黃仁勳同時宣布一項特別的革新NVIDIA NVLink Fusion,NVLink Fusion 讓你可以打造半客製化的 AI 基礎設施,不只是半客製化晶片,因為那是過去的方式,現在你要打造整體的 AI 基礎設施。每個人的 AI 基礎設施可能都不盡相同,有些人可能需要更多的 CPU,有些則需要更多 NVIDIA GPU,還有人可能是某家企業的半客製化華碩系統,建造這類系統異常複雜,且多半缺少一項關鍵元素─NVLink。

NVLink 讓你能夠擴展這些半客製化系統,打造極為強大的電腦,今天,我們推出 NVLink Fusion,NVLink Fusion 的運作方式包含了 NVIDIA CPU、NVIDIA GPU、NVLink 交換器,以及 NVIDIA 的 Spectrum X 或 InfiniBand 網路卡、連接介面和交換器,整個端到端的系統和基礎設施都是 NVIDIA 打造。

當然,使用者也可以依需求混搭組合。今天,NVIDIA讓你能在電腦層級混搭組合,這就是使用客製化 ASIC 時會做的事情。NVIDIA有優秀的合作夥伴,接下來會宣布,他們將協助把你的專用 TPU 或特殊 ASIC、加速器整合進系統,這些加速器不必只限於 Transformer 加速器,可以是任何你想要整合進大型擴展系統的加速器。

NVIDIA創造了 NVLink 晶片組件,這基本上是一個貼合你的晶片的小交換器,有可供你整合進半客製化晶片的 IP,整合後,這些晶片能直接安裝在剛才提到的運算板上,並融入我剛剛展示的 AI 超級電腦生態系統。

黃仁勳表示,也許你想使用自家 CPU,你已經花了很長時間在打造自家 CPU,建立了龐大的生態系統,並想將 NVIDIA 融入你的生態系統,現在我們讓你可以做到,透過建置自家定制 CPU,我們提供 NVLink 晶片對晶片的介面,連結 NVLink 晶片組件,使其直接與 Blackwell 晶片和下一代 Rubin 晶片貼合整合。

這一系列令人驚嘆的成果,現在變得靈活且開放,讓任何人都能輕鬆整合進去。你的 AI 基礎設施可能會包括一些 NVIDIA 元件,也可能有大量自家元件,還有許多 CPU 和加速器,也可能還有大量 NVIDIA GPU。

因此,不管怎麼組合,你都能享有 NVLink 基礎設施和 NVLink 生態系的優勢,這些系統能完美對接 Spectrum X,以及其他工業等級設計,背後擁有龐大的產業合作夥伴生態系支持,而這些合作夥伴已經完成大量前期準備。

黃仁勳強調,這就是 NVLink Fusion,無論你是否完全購買NVIDIA的產品,他說他都覺得非常棒,沒有什麼比你完全採用 NVIDIA 產品更讓他高興了,這點希望你們知道,但若只是部分採用 NVIDIA,他也同樣感到興奮和欣慰。

黃仁勳提到有一些出色的合作夥伴,包括 Elcheck、Astera Labs、Marvell 以及重要夥伴聯發科,他們將與NVIDIA合作,支援為超大規模客戶打造半客製化 ASIC,或者支援 CPU 廠商打造這些產品,擔任半客製化晶片供應商。

此外,富士通和高通也在打造支援 NVLink 技術的 CPU,以整合進NVIDIA的生態系統。Cadence 和 Synopsys 也與NVIDIA合作,取得NVIDIA的 IP,讓他們能支持你們所有晶片的開發。

這個生態系統非常龐大且強大,此處只是突出展示 NVLink Fusion 生態系統。一旦你與他們合作,將立即可整合進整個 NVIDIA 生態系,讓你有能力擴展成為大型 AI 超級電腦。

新產品DGX Smart合作夥伴包括Dell、HPI、華碩、微星、技嘉、聯想

黃仁勳接下來介紹一些新的產品類別,可能在幾周內,有非常強大的合作夥伴,包括Dell、HPI、華碩、微星、技嘉、聯想,這些都是令人難以置信的合作夥伴。

這是 DGX 智慧生產單元,這是我們的版本。不過,我們的合作夥伴正在打造各種不同版本,這是為 AI 原生開發者設計的。如果你是開發者、學生或研究人員,不想每次都要開啟雲端,準備環境,然後使用完畢還要清理,你只想擁有一台屬於自己的 AI 雲端,放在身邊,隨時開啟,隨時等待你使用。

它讓你可以做原型設計和早期開發,這非常令人驚奇,這就是 DGX Smart,擁有一拍浮點運算能力和 128GB 記憶體。2016 年他曾展示 DGX One 時,這只是前面板,他笑說他搬不起整台電腦,它有 300 磅重,這是 DGX One,也是擁有一拍浮點和 128GB 記憶體。

當然,這裡的 128GB 是 HDM 記憶體,而 DGX Smart 用的是 128GB 的 LPDDR5X 記憶體,性能實際上相當接近,但最重要的是,在這台設備上能做的工作,和在 DGX One 上做的工作是一樣的,這是十年來一項驚人的成就。這就是 DGX Smart,適合任何想要擁有自己 AI 超級電腦的人。價格方面,他會讓我所有合作夥伴自行定價,不過有一點是肯定的,每個人都可以在聖誕節前擁有一台。

DGX Station可以運行一兆參數的 AI 模型

如果覺得 DGX Smart 不夠大,還想要一台真正屬於自己的個人電腦,黃仁勳介紹另一台 Junipol、桌上型電腦,也會由 這些合作夥伴等提供,也可以從 Box、Lambda 這些頂尖工作站公司購買。這將是個人 DGX 超級電腦,這台電腦提供了能從牆壁插座獲得的最大性能,可以把它放在廚房,但幾乎是極限。如果你在廚房使用這台電腦,然後有人開微波爐,我想那就是電力的極限。

這就是極限,這是牆壁插座所能提供的最大性能,而這台就是 DGX Station。這台和我之前展示的超大系統使用相同的程式設計模型,這是令人驚嘆的地方。只有一種架構,且這台擁有足夠的容量和性能,可以運行一兆參數的 AI 模型。 Llama 是 Llama 70D,一兆參數的模型在這台機器上可以非常順利地運行,這就是 DGX Station。

黃仁勳談到,記住這些系統是 AI 原生的,它們是為這一新世代軟體打造的 AI 原生電腦,這些不必兼容 x86,不必運行傳統的 IT 軟體,不必運行虛擬機,也不必運行 Windows。這些電腦專為現代 AI 原生應用設計,當然這些 AI 應用可以成為傳統和經典應用可以調用的 API,但為了將 AI 帶入新世界,這個新世界是企業 IT,我們必須回歸本源,重新定義計算,將 AI 融入傳統企業計算。

企業的新能力是「代理型 AI」、全新推出的 RTH Pro 企業與 Omniverse 伺服器

在企業計算方面,實際上包括三層:不僅是計算層,還有存儲和網絡。既然 AI 改變了一切,很有道理 AI 也必須改變企業 IT 的計算、存儲和網絡層。底層必須徹底改造,而我們正處於這個過程中。今天將展示一些新產品,這些產品開啟並解鎖了企業 IT,它們必須與傳統 IT 產業協作,並且必須增添新的能力。

企業的新能力是「代理型 AI」。基本上是數位行銷活動經理、數位研究員、數位軟體工程師、數位客服、數位晶片設計師、數位供應鏈管理者。這些都是我們過去所做工作的 AI 數位版本。從很多方面來看,它們是數位工作者,是數位員工,世界正面臨勞動力短缺問題。到 2030 年,勞動力短缺將達到約 3000 到 5000 萬。這實際上限制了世界的成長能力。所以現在我們有了這些數位代理,它們可以與我們一起工作。

現在 NVIDIA 的所有軟體工程師中,已有 100% 擁有數位代理與他們協同工作,幫助他們更有效率地開發更好的代碼。未來你會看到這樣一層,這是我們的願景,會有一層代理型 AI,AI 代理。那麼世界會怎樣?企業會怎樣?當我們有了負責人力資源(HR)管理人類員工,未來 IT 將成為數位員工的 HR。因此我們必須為今天的 IT 產業創造必要的工具。

今天的 IT 人員,必須能夠管理、提升及評估整個家族的 AI 代理,這些代理都在企業內部運作,這就是我們想要打造的願景。但首先,我們必須重新發明運算。請記住我剛才說過的,企業 IT 使用 x86 平台,執行傳統軟體,如 VMware、IBM Red Hat 或 Nutanix 的虛擬機監控程式,以及大量經典的應用程式。我們需要讓電腦能做相同的事,但同時加入自動化 AI 的新功能。

這是全新推出的 RTH Pro 企業與 Omniverse 伺服器,這台伺服器什麼都能執行,當然包含 x86 架構,它可以執行所有經典的虛擬機監控程式,也能在這些虛擬機中執行 Kubernetes。因此,您的 IT 部門想要管理網路、管理叢集以及協調工作負載的方式,完全一樣,它甚至能串流 Citrix 和其他虛擬桌面到您的電腦。如今世界上所有運行的軟體,都應該能在這裡運行。Omniverse 在這裡運行得非常完美。

除此之外,這同時也是企業 AI 代理的電腦,這些 AI 代理可以是純文字型態,也可以是電腦圖形,就像是小 T.J. 一樣,會來幫助您工作。這些 AI 代理可呈現文字、圖形,甚至影片形式,所有這些工作負載都能在此系統運行。無論是哪種模式,全世界我們所知道的每一個模型、每一個應用程式,都應該能在這裡執行。事實上,連 Crysis 遊戲也可以在這裡運行。

對於 GeForce 遊戲玩家來說,這裡沒有 GeForce 玩家。黃仁勳介紹連接這 8 張全新 Blackwell RTX Pro 6000 GPU 的硬體,這是一張全新的主板,這個主板實際上是一個交換網路,CXA 是一種新類別晶片,是首款以交換網路為核心的晶片組,也是全球最先進的網路晶片。CXA 現已量產。可以將 GPU 插上 CXA,它們位於主機板後方,透過 PCI Express 連結,CXA 負責 GPU 間的溝通。網路頻寬非常高達 800 Gbps,這是插入此處的收發器,每張 GPU 都有自己的網路介面,所有 GPU 彼此之間可進行東西向流量的通訊,效能驚人。

令人驚豔的是 RTX Pro 的表現,要思考 AI 工廠世界的效能方式,是以「吞吐量」來衡量。這裡的「每秒代幣數」是 Y 軸,產出代幣越多表示吞吐量越高。然而,每個 AI 模型不盡相同,有些模型需要更多推理能力,因此每位用戶所需的效能必須很高,也就是每秒代幣數必須很高。工廠常面臨的問題是,吞吐量高或延遲低兩者很難兼得。挑戰在於如何打造作業系統,使我們同時擁有高吞吐量(Y 軸)和極低的延遲(每位用戶的每秒代幣數)。

這張圖展示了整體運算工廠的效能。不同顏色代表要達成效能所需採用的不同 GPU 配置方法,譬如有時需管線平行,有時需專家平行,有時要批次運算,或進行推測性解碼,有時則不需,這些演算法需依工作負載分別且不同地應用。組合結果形成圖中外圍區域,代表工廠的能力。

請注意,Hopper 是全球最知名的電腦,Hopper H100 HGX 售價約 225,000 美元,您剛看到的企業級 Blackwell 伺服器效能是其 1.7 倍。這真是令人驚嘆。下面是 Lama70B,以及 DeepSeq R1,後者效能是 Hopper 的四倍。DeepSeq R1 因經過高度優化,對全球 AI 產業來說是一大福音,帶來許多計算機科學突破,也開啟美國與全球許多研究領域的新機會。它改變了人們對 AI 推論和推理的看法,對產業及世界貢獻良多。

ThinVR H100提供一個比較視角,如果要打造企業 AI,NVIDIA現在有很棒的伺服器與系統,這是一台能執行所有應用程式的電腦,擁有驚人效能,不論是 x86 或 AI 工作負載,都能運行。我們的 RTX Pro 伺服器已經在業界各夥伴間大量量產,這很可能是我們有史以來投入市場最大規模的系統。