輝達財報|黃仁勳QA一次看!中國帶來1.5兆商機 有信心Blackwell可賣大陸

【財經中心/台北報導】輝達在美股周三盤後公布財報,在之後的財報電話會議上,華爾街分析師針對輝達在中國市場的機會、Blackwell平台的效能優勢及公司因應ASIC競爭的策略進行提問。

📌 本文摘要重點 (這是什麼?)

輝達執行長黃仁勳則強調公司在AI基礎設施領域的領先地位。他表示,AI 驅動的新工業革命已開啟,Blackwell作為下一代AI平台表現亮眼,GB300進入全速量產階段,Rubin平台按計畫推進,長期看好全球AI基礎設施市場達3~4兆美元。他還指出AI所帶來的變革性影響,並說,一場新的工業革命已經開啟,AI競賽已打響。財聯社也整理黃仁勳回答分析師提問內容。

Cantor Fitzgerald分析師CJ Muse問:從宏觀視角談談2026年成長的展望,希望能同時說明網路業務與資料中心業務的成長規劃。

黃仁勳:從核心層面來看,成長驅動力源自於推理型智能體AI(reasoning agentic AI)的演進與落地。過去,聊天機器人的互動模式是「單次觸發」,你給出一個指令,它產生一個答案,現在的AI 能夠自主展開研究、進行思考並制定方案,甚至會調用工具。這個過程被稱為深度思考,AI 的思考時間愈長,產生的答案品質愈高。

全球AI基礎設施商機達3~4兆美元

相較於「單次觸發」 模式,推理型智能體AI 模型所需的算力可能達到100倍、1000倍,若涉及更複雜的研究任務(如大量文獻閱讀與理解),算力需求甚至可能更高。

過去一年,AI 技術取得了巨大進步,智能體系統與推理系統的出現更是具有革命性意義。我們研發Blackwell NVLink 72系統,一款機櫃式運算系統,這項研發工作已持續數年;去年,我們完成了從NVLink 8(節點級計算,每個節點即為一台電腦)到NVLink 72(機櫃級計算,每個機櫃即為一台電腦)的技術躍遷。將NVLink 72拆解為機櫃級系統的技術難度極高,但成果也十分顯著:憑藉NVLink 72,我們實現了算力數量級的提升,進而大幅優化能效及成本效益。

至於長期展望,未來幾年(更具體地說,未來5年),我們將憑藉Blackwell、Rubin及後續平台擴大規模,最終把握全球3兆至4兆美元的AI基礎設施機會。過去幾年,光是四大雲端服務供應商(CSPs)的資本支出就實現了翻倍,總額已達約6000 億美元。由此可見,我們正處於AI 基礎建設的起步階段。

美國銀行分析師Vivek Arya:輝達多家大型客戶已啟動或計劃啟動專用積體電路(ASIC)專案,是否存在市場重心從輝達GPU 轉向ASIC 的可能?客戶如何平衡商用晶片(merchant silicon)與ASIC的使用比例?

輝達優勢在產品涵蓋所有雲端平台

黃仁勳:輝達的產品與ASIC有本質區別,目前確實有許多ASIC專案啟動,也湧現出不少相關新創企業,但最終能實現量產的產品寥寥無幾,核心原因在於ASIC研發難度高,加速計算與通用計算不同,在通用計算中,你編寫軟體後只需將其編譯到處理器即可運行,加速計算是一個全棧協同設計 問題。

過去幾年,AI工廠的複雜度大幅提升,因為其需解決的問題規模呈指數級成長,這是全球迄今面臨最複雜的電腦科學難題,因此整個技術棧的設計難度極大。

輝達的優勢之一在於,我們的產品涵蓋所有雲端平台,與所有電腦廠商均有合作;從雲端資料中心到本地部署、從邊緣設備到機器人,我們都採用統一的程式設計模型。

我們的平台具備3大優勢:1是能夠適配任意模型架構的演進需求;2是應用場景全覆蓋;3是能加速AI 全流程,從資料處理、模型預訓練,到基於強化學習的模型微調,再到最終的推理部署。因此,搭載輝達平台的資料中心不僅效用最高,使用壽命也遠長於其他平台。

如今的AI系統已成為極為複雜的綜合性問題。人們往往只專注於晶片本身,例如大家常討論的某款ASIC 晶片,但要研發Blackwell 與Rubin 這樣的完整平台,我們需要構建一整套技術體系,包括能連接高速內存的CPU(智能體AI 需要大容量KB緩存,因此內存具有極高能交換乙太網路交換器),以及最新推出的跨域擴展交換器(Spectrum XGS),透過這類交換機,我們可搭建多吉瓦級算力互聯的AI超級工廠。我們本周已在Hotchips(半導體產業會議)上發布Spectrum XGS 技術。

4大雲端業者今年資本支出達6000億美元

我們的產品之所以能涵蓋所有雲端平台,是有充分理由的,不僅因為我們的能源效率是所有運算平台中最高的,更因為在資料中心受電力限制的當下,能源效率直接決定營收規模。正如我之前所說,「採購量愈大,成長空間愈大」。基於這些原因,全球所有雲端廠商、新創公司與電腦廠商均選擇輝達,我們為AI工廠提供全面的解決方案。

Melius分析師Ben Reitzes:輝達在AI市場規模中能佔多大?目前,輝達在整個基礎設施運算領域市佔已非常高,且要實現3 兆至4 兆美元的支出目標是否擔心某些瓶頸問題,例如電力供應方面的限制?

黃仁勳:光是全球4大超大規模雲端廠商(hyperscalers)的資本支出,在2年內就翻倍,隨著AI革命全面推進、AI競賽已打響,這類資本支出已增加至每年6000億美元,從現在到本世季末還有5年時間,這6000億美元只是4家超大規模雲端廠商的支出規模。

除此之外,其他企業也在建置本地部署(on prem)的資料中心,全球各地的雲端服務供應商也持續投入建置。目前,美國運算資源約佔全球總量60%。長期來看,AI的發展規模與成長速度理應與GDP 相匹配,當然,AI 本身也將推動GDP 加速成長。因此,英偉達在AI 基礎設施領域的貢獻佔有重要地位。

輝達已成功轉型為AI基礎設施企業

以一座1 吉瓦(gigawatt)規模的AI 工廠為例,建設成本通常在500 億至600 億美元之間(誤差幅度±10%),輝達在其中的貢獻佔比約35%(誤差幅度±5%)。

輝達提供的並非只是GPU,輝達以研發並發明GPU而聞名,但在過去 10年間,我們已成功轉型為AI基礎設施企業,光是打造一套Rubin AI 超級電腦,就需要6種不同類型的晶片;若要將其擴展到1吉瓦規模,則需要數十萬個GPU計算節點以及大量機櫃設備。

輝達產品的單位能耗性能,直接決定AI工廠的營收成長,兩者有直接關聯。以一座100 兆瓦(megawatt)的工廠為例,其100 兆瓦電力對應的性能水準,決定工廠的營收規模,本質上就是「工廠每100 兆瓦電力產出的Token數量」。此外,我們產品的「每美元效能比」也極具競爭力,這使得顧客能獲得極高的毛利率。這些(電力、成本等)都是未來產業發展需要因應的限制因素。整體而言,未來5年全球AI 基礎設施支出達到3兆至4兆美元的規模,是相當合理的預測。

摩根士丹力分析師Joe Moore:你之前提到,全球約半數AI 軟體相關業務集中在中國,輝達在中國業務的成長空間有多大?另外,最終推動Blackwell 架構取得對華出口許可,對輝達而言有多重要?

估今年中國市場對輝達帶來500億美元規模

黃仁勳: 據我估算今年中國市場為我們帶來的機會規模約為500億美元(約1.5兆台幣),有鑑於全球AI市場整體均在成長,預計中國市場規模每年可實現50%左右的成長,中國是全球第二大運算市場,同時也是AI 研究人員的聚集地,全球約50%的AI 研究人員來自中國,絕大多數領先的開源模式也誕生於中國。因此,美國科技企業能否進入這個市場,具有十分重要的意義。

中國湧現的開源模型品質極高:例如DeepSeek已獲得全球關注,Q1、Kimi、豆包等模型的表現也十分出色,這些開源模型極大地推動了全球企業對AI 的採用,因為企業希望構建屬於自己的客製化專有軟體棧,而開源模型對企業而言至關重要。

開源技術意義重大,美國企業能否參與其中也同樣關鍵。中國市場的規模未來將十分龐大,我們正與美國政府相關部門溝通,強調美國企業進入中國市場的重要性。因此,我認為輝達將Blackwell架構引入中國市場的可能性是確實存在的。

輝達維持每年一次產品迭代周期

高盛分析師Jim Schneider:希望進一步說明對Rubin平台後續產品迭代的看法?該平台能為客戶帶來哪些新增能力?相較於Blackwell平台的升級幅度,Rubin平台的提升幅度會更大、更小,還是基本上相當?

黃仁勳:關於Rubin 平台,我們目前保持著每年一次的產品迭代周期。選擇這一周期的核心原因是,我們希望透過持續迭代幫助客戶降低成本、最大化營收。

當我們提升「每瓦性能比」(即單位能耗的Token產生量)時,本質上是在直接推動客戶的營收成長。對於推理型系統而言,Blackwell 平台的「每瓦效能比」 相較於Hopper 平台實現數量級的提升,由於所有資料中心本質上都受電力容量限制,因此,採用Blackwell 平台的資料中心,無論是相較於我們過往的產品,還是目前市場上的其他解決方案,都能實現營收最大化。

此外,Blackwell 平台的「每美元績效比」(即單位資本投入的表現)也極具優勢,這能幫助客戶提升毛利率。只要我們能為每一代產品注入創新概念,就能透過推出新架構,持續提升客戶的營收能力、AI 功能水準與毛利率。

預期明年也是輝達創紀錄的1年

我們建議合作夥伴與客戶以年度節奏規劃資料中心建置。Rubin 平台將包含多項創新,它已儲備諸多出色的技術理念,我很期待分享,但現在還不能透露更多,後續會在GTC大會詳細說明。

不過,在接下來的一年裡,我們將全力推動目前產品的產能提升,包括Grace Blackwell平台、GB200(產品型號),以及最新的Blackwell Ultra平台、B300(產品型號),並加速資料中心部署。顯然,今年已是創紀錄的一年,我預計明年也將是創紀錄的一年。

預期到2030年AI成長快速

瑞銀集團分析師Timothy Arcuri:你說AI 市場的複合年增長率(CAGR)為50%。我想了解,對明年市場狀況的可預見性有多高?對於貴公司資料中心業務明年的營收成長而言,50% 的複合年增長率是否是合理的目標?

黃仁勳:我們已從大型客戶獲得關於明年的合理預測,這些預測規模相當可觀。此外,我們仍在不斷贏得新業務,市場上也持續湧現大量新創企業。去年專注於AI 原生業務的新創公司獲得融資額就達1000 億美元,今年尚未結束,這筆融資額已升至1800億美元。

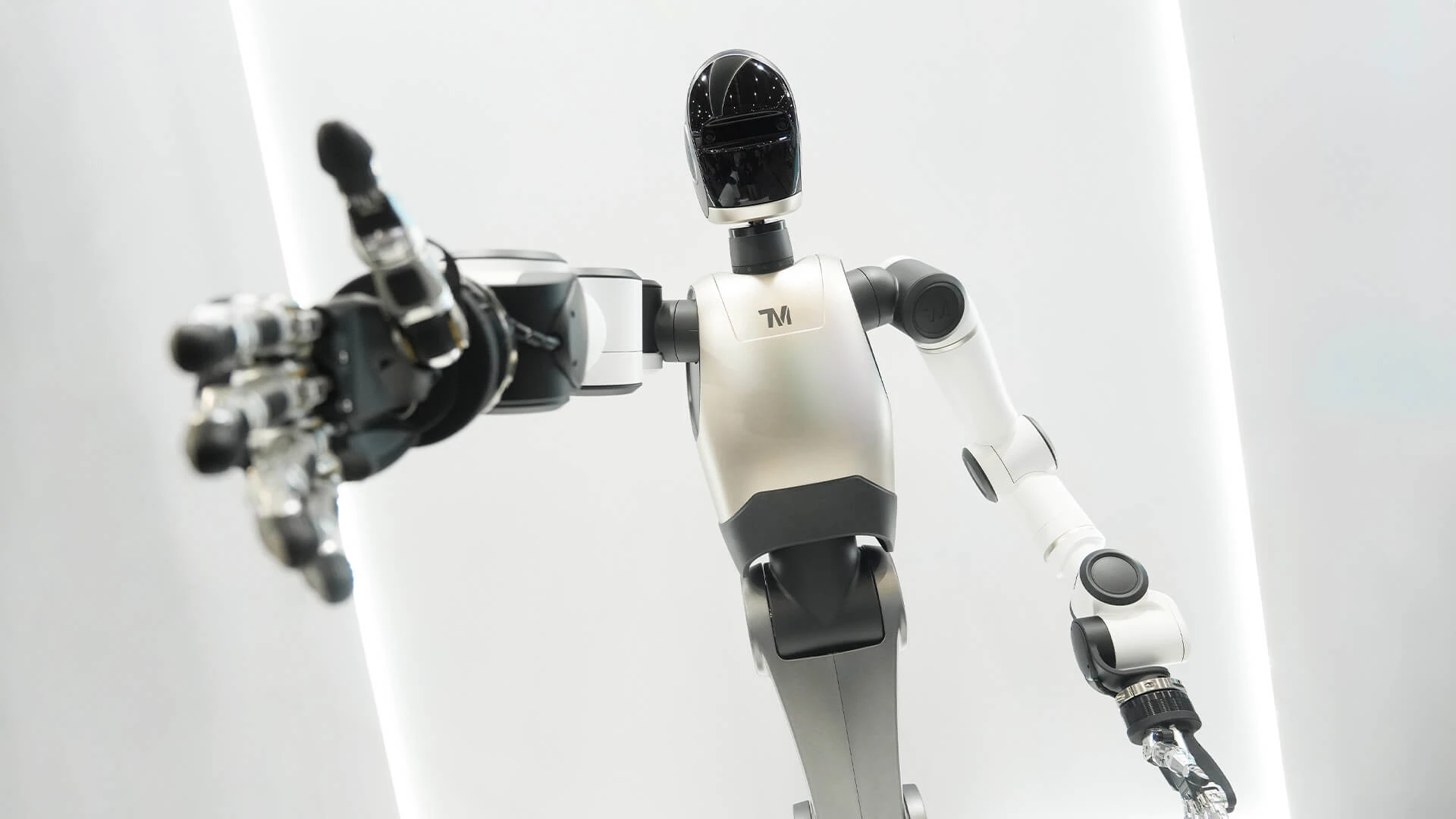

若聚焦「AI 原生」 領域,那些已產生營收的領先AI 原生新創企業,去年營收總額為20 億美元,今年則達到200億美元。明年營收較今年再成長10倍,並非不可能。同時,開源模式的發展正吸引大型企業、SaaS(軟體即服務)公司、工業企業及機器人企業加入AI 革命,這將成為另一個成長來源。

從長期展望來看,過去2年,僅大型超大規模雲端廠商(hyperscalers)的資本支出就翻倍,目前每年資本支出規模約為6000億美元。對我們而言,在這6000億美元的年資本支出中佔據可觀市佔,並非不切實際,我認為在未來數年,乃至整個本十年期間,我們都將面臨成長迅猛、規模龐大的成長機會。