數發部研擬AI風險分類框架 助各部會檢視潛在衝擊

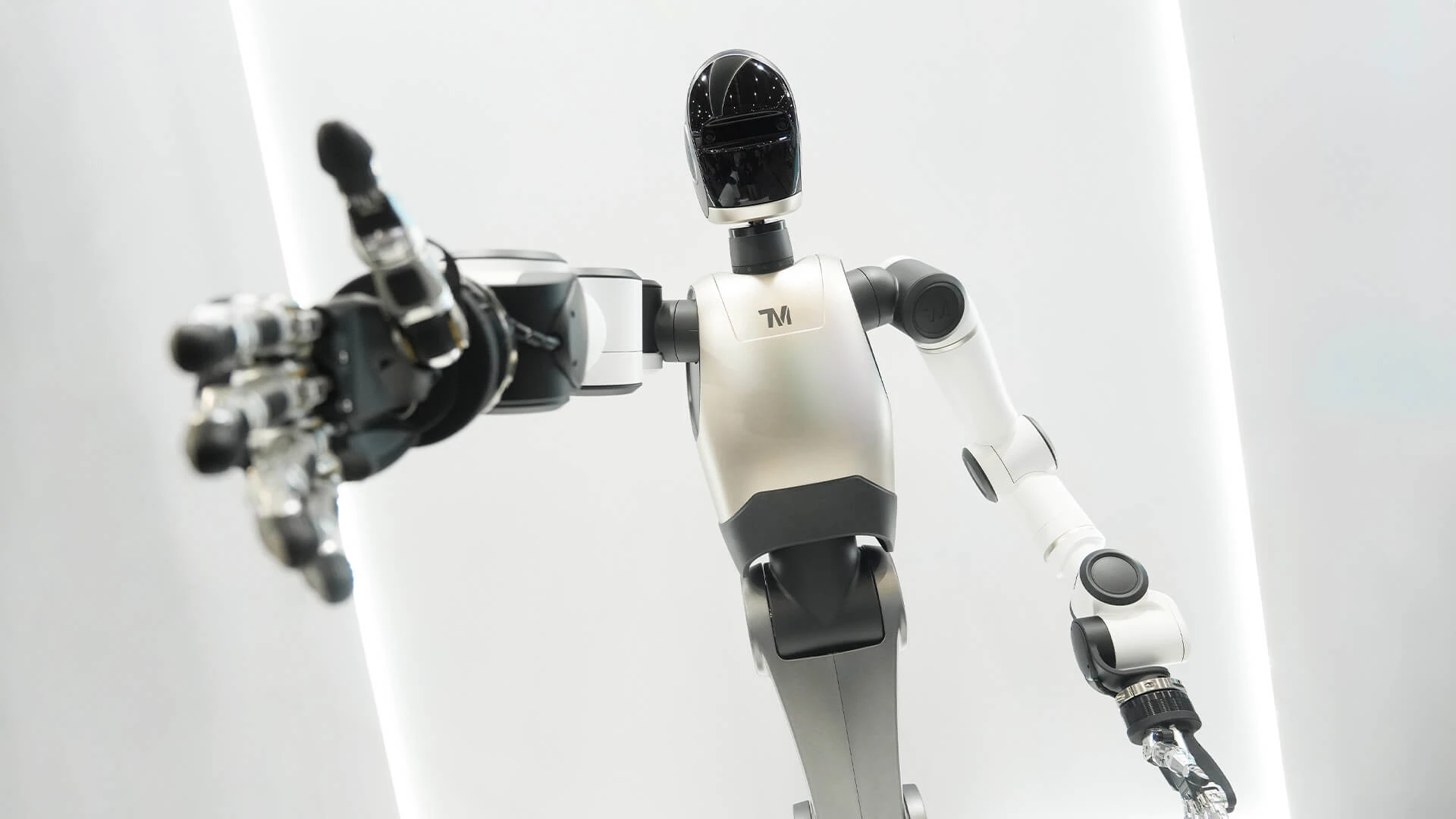

【記者陳力維/綜合報導】隨著人工智慧(AI)科技發展迅速,如何在鼓勵創新的同時兼顧人權與風險管理,成政府重要課題。數位發展部(數發部)目前正著手研擬「AI風險分類框架」,目的在於協助各目的事業主管機關檢視AI新科技可能帶來的負面影響,例如是否造成欠缺AI技能者的就業歧視,進而引發大量失業問題。數發部表示,此框架正進行最後調修,後續將視行政院通過的《AI基本法草案》立法進度,推動相關作業。

《AI基本法草案》定錨七大原則 兼顧創新與人權保障

中央社報導,行政院會已於8月底通過《AI基本法草案》,將以「鼓勵創新」兼顧「人權保障」作為主軸,為國家AI發展定錨政策方向。在鼓勵創新方面,草案明定政府將辦理AI相關產業補助、獎勵或提供財政優惠措施,並推動AI教育、人才培育、資料開放與創新實驗環境的建置。

在保障人權方面,草案以風險管理為基礎,推動AI風險分類框架,並要求透過評估驗證工具,避免AI應用違法。數發部數位策略司司長蔡壽洤指出,草案揭示了七大原則,包括永續性、人類自主性、隱私保護及資料治理、安全性、透明及可解釋性、可問責性等。例如,「透明及可解釋性」意指AI生成的影像等產出應明確標示為AI產物;「可問責性」則要求AI開發者應限制AI不得鼓勵犯罪,使用者亦不得利用AI犯罪。

風險分類框架不「一刀切」 聚焦系統、人機互動與社會衝擊

蔡壽洤說明,由於AI在智慧醫療、智慧交通等各產業的使用情境與強度差異甚大,政府不採取「一刀切」的分級方式管理。數發部將依據AI基本法的七大原則建立「AI風險分類框架」,供各主管機關依循,並針對特定技術在特定場域的運作情況,訂定相應的管理規範。

蔡壽洤進一步解釋,在AI基本法的風險治理體系下,AI風險分類框架可初步分為三大類:

📌AI系統與服務:涵蓋是否涉及偏見、歧視等議題。

📌人機互動:關注是否產生過度依賴或因不當操作而衍生風險。

📌社會結構與環境衝擊:包括是否造成能源過度消耗、大量失業等問題。

檢核表將引導風險識別 高風險認定由各主管機關判斷

數發部規劃制定檢核表,以引導各目的事業主管機關依其執掌內容識別AI風險。蔡壽洤指出,高風險AI的認定將由各主管機關依其產業的實際情況進行判斷。因此,高風險AI可能造成的損害風險,其責任歸屬、歸責條件與救濟、補償及保險機制,也將由各主管機關自行訂定。

為協助主管機關認定高風險AI應用,數發部將在風險分類框架中提供參考依據。此外,AI產品與系統評測中心(AIEC)也將提供評估驗證工作與方法。數發部將與衛福部、金管會、交通部和勞動部等相關部會持續協作,調整檢核表細節,期望建立可實際操作的風險識別工具。

避免就業歧視與技能落差 勞動部將研議輔導機制

針對AI可能導致的人力衝擊,蔡壽洤強調,AI基本法草案規範政府將輔導因AI而失業者就業。這項工作將由勞動部等相關單位進行研議,主要目的在於避免雇主因導入或使用AI而造成就業歧視或終止勞動契約的情形。同時,也希望能避免員工因技能落差而導致職場競爭力下降。數發部目前正與勞動部研議討論相關輔導與應對措施。

蔡壽洤強調,「AI風險分類框架」會搭配《AI基本法草案》於立法院的審查時程,以及行政院的相關決議,適時對外公告。在正式上路前,數發部也會多方蒐集意見進行調修,以確保該框架處於最適合的狀態,讓社會大眾能更安心、負責任地使用AI。