廣告

黃仁勳再引爆全球記憶體行情 輝達的「革命性架構」到底是什麼?

【財經中心╱台北報導】全球記憶體族群股價持續大漲,尤其是輝達執行長黃仁勳在CES發表的主題演講和新產品後,讓原本就已非常火熱的記憶體行情進一步加溫。

黃仁勳表示,儲存「目前仍是一個完全未開發的市場」,AI驅動的儲存需求已經超過現有基礎設施的容量。「我們現在處理的上下文記憶體、token記憶體和KV cache(鍵值快取)的數量都太大了,舊的存儲系統根本無法滿足需求。」

他說,「AI正在重塑整個運算堆疊,現在,也包括儲存。AI不再是一次性問答的聊天機器人,而是能夠理解物理世界、進行長周期推理、保持事實一致性、調用工具完成真實工作的智慧協作者,並具備短期與長期記憶能力。」

輝達發表全新推理情境記憶體儲存平台

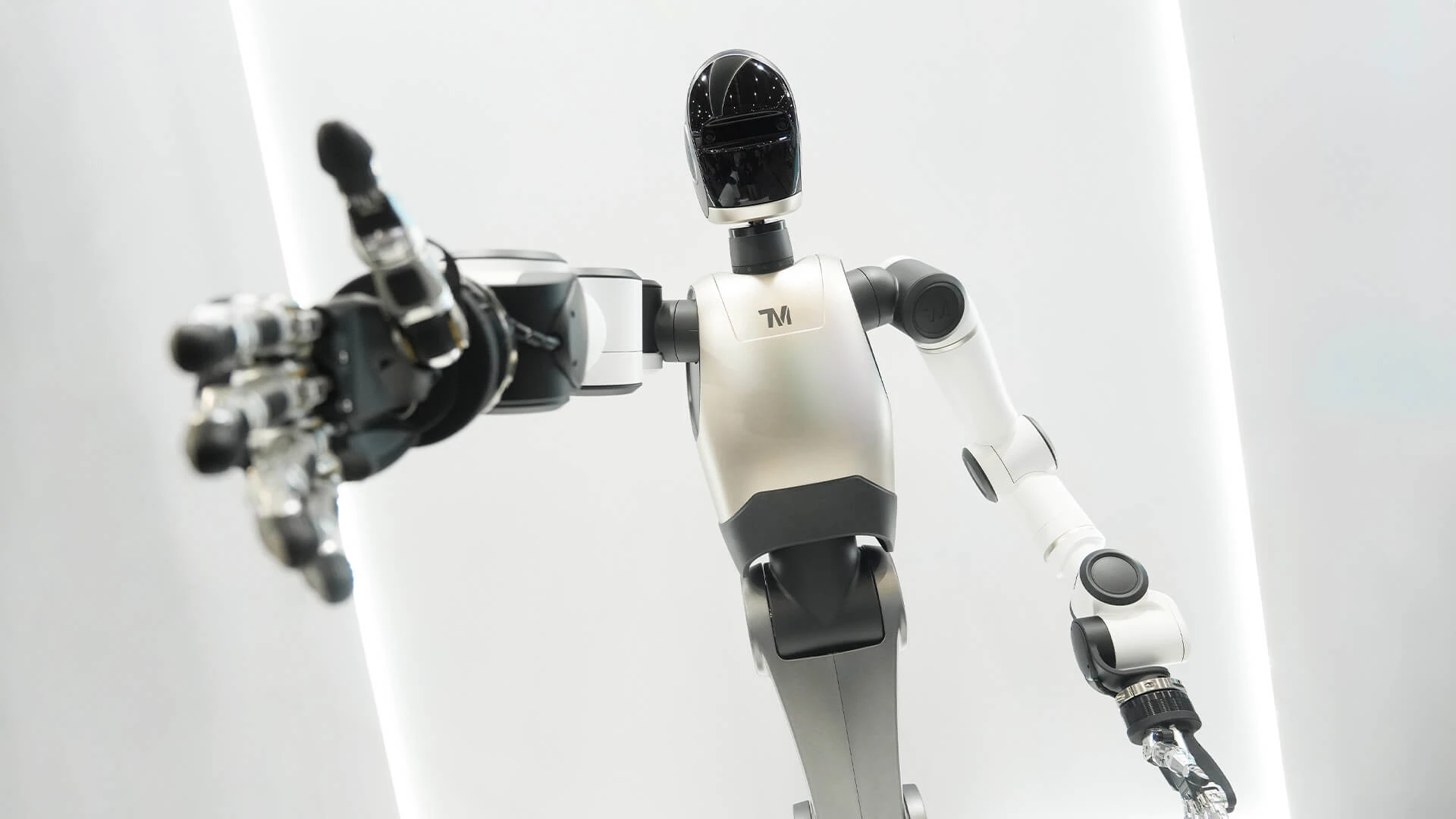

之後他宣布輝達將推出由BlueField-4 驅動新一代AI原生儲存基礎架構,重構面向下一階段AI的儲存架構,並用「革命性」一詞來形容這項創新。

新儲存平台是什麼?輝達的儲存新平台全稱為NVIDIA Inference Context Memory Storage Platform(輝達推理情境記憶體儲存平台)。根據官方介紹,該平台透過擴展GPU可用記憶體容量,為情境記憶提供基礎設施支持,實現跨節點的高速共享。

從架構上來說,這個平台其實是為了AI推理專門打造一層高速、低能耗的「上下文記憶」儲存層,將原本只能放在昂貴且有限的GPU HBM的KV cache擴展到NVMe快閃記憶體和跨機群共享。

輝達新平台有何特別之處?

與傳統儲存方案相比,能將每秒可處理的token數提升最高5倍,並達到最高5倍的能源效率最佳化。

本次輝達的新平台是首次將AI推理KV快取當成獨立基礎設施層來設計。在此之前,一般KV快取有3個路徑選擇:GPU的HBM(快,但貴且容量極小)、 CPU記憶體(稍慢且規模有限)、SSD/儲存(便宜但延遲不可控)。

黃仁勳在CES的演講中,用「革命性」來形容這項創新。他指出,這本質上是在機架內直接加入一個極快的KV快取上下文儲存系統。整個產業之所以如此興奮,是因為對於現今所有進行大規模Token產生的機構企業而言,KV快取都是一個痛點。

「所以,我們要創建一個新平台、一個新處理器來運行整個Dynamo KV快取上下文記憶體管理系統,並將其放置在離機架其餘部分非常近的地方,這個想法是完全革命性的。」他說。

AI推理瓶頸從運算轉向上下文儲存

在新平台的介紹中,「KV快取」一詞頻繁出現,某種程度上來說,這也是促使輝達開發新平台的關鍵原因之一。

黃仁勳在最新的CES演講中強調,AI推理瓶頸正從運算轉向上下文儲存,隨著模型規模提升以及使用者使用量的提升,AI處理需要多輪對話、多步驟推理的複雜任務時,會產生大量情境資料,傳統網路儲存對短期情境而言效率過低,AI儲存架構需要重構。

這種海量的上下文資料通常以KV快取的形式存在,對推理準確性、使用者體驗以及互動連續性—即備受追捧的「個人化AI」能力至關重要。

「推理時代」下,KV快取顯存佔用隨Token數量線性成長,同時KV Cache的最佳化效果也與文字長度呈正相關。